L’analytique 3.0 et l’industrie 4.0 vont se marier, et l’industrie analytique 4.0 deviendra ainsi la nouvelle star

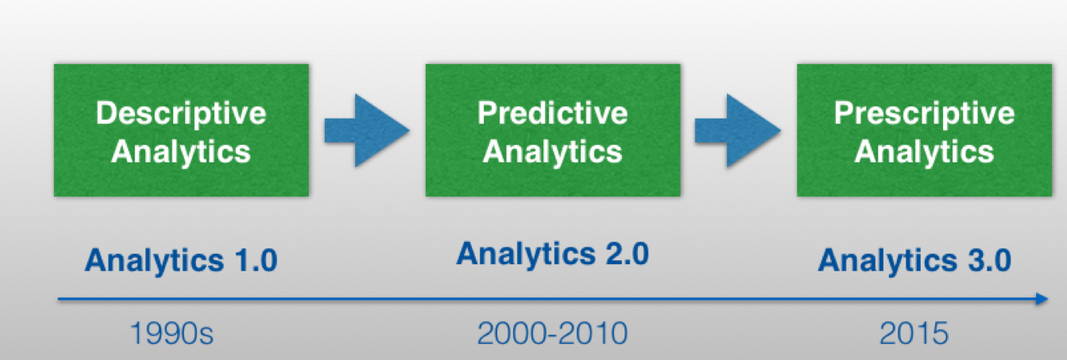

Analytique 3.0: après l’analyse prédictive, l’analyse prescriptive

Abb.1: Die Entwicklung der Analytic nach Davensport

L’analytique 3.0 a la réputation d’être le successeur du Big Data. Ce concept fut développé aux États-Unis par le professeur Thomas Davensport. On ne demande plus seulement « Que va-t-il se passer ? », dans le sens de l’analytique prédictive, mais aussi « Pourquoi est-ce que cela va arriver ? », dans le sens de l’analytique prescriptive. Des questions « quoi » et « pourquoi » émergent de nouvelles relations de cause à effet et de nouvelles perceptions dans la chaine causale.

L’analytique 3.0 comporte de nouvelles technologies du Big Data, en plus des techniques conventionnelles du décisionel, lesquelles rendent possible la communication en direct de grandes quantités de données aux formats différents. L’interprétation des données est effectuée par des infrastructures et des technologies en mémoire, avec l’aide d’algorithmes d’apprentissage automatique et d’exploration de données. À la différence de l’entrepôt de données conventionnel, il n’existe pas de frontière en termes de formats de données, et la modélisation des données est drastiquement simplifiée.

Au centre de l’analytique 3.0 se trouve l’algorithme. Les algorithmes d’apprentissage automatique doivent extraire automatiquement les informations depuis les données. Cela se déroule sans interface homme-machine. Afin de le rendre possible, les algorithmes apprennent et forment des modèles avec de petites quantités de données (fournies par des hommes). Les algorithmes sont également partiellement autodidactes ; c’est pourquoi les modèles et les prévisions s’améliorent au cours du temps.

L’exploration de données a en fait une importance capitale au sein de l’analytique 3.0. Cependant, il existe ici toujours une personne concrète dans le processus de révélation ou de prédiction. La solution d’un problème concret et complexe est typiquement au premier plan. On souhaite par exemple comprendre un évènement complexe sur lequel un grand nombre de facteurs inconnus ont exercé un effet. ’exploration de données se sert de beaucoup d’algorithmes d’appretissage automatique, et inversement.

L’analytique 3.0 est une coopération de technologie et de mathématiques. C’est à la fois la réalité et le futur. L’analytique 3.0 est utilisée depuis plusieurs années, des recherches et des développements y sont consacrés simultanément dans beaucoup d’universités et d’entreprises.

Le nombre d’algorithmes utilisables est de nos jours d’ores et déjà très grand, et le domaine subit beaucoup de changements. Il s’y ajoute chaque jour de nouveaux algorithmes, tandis que ceux existant déjà sont améliorés. Une grande partie des algorithmes est publique et il est possible de se les procurer sous différents paquets de logiciels libres, tels que R, Mahout, Weka, etc. D’autres algorithmes sont des produits commerciaux et sont de ce fait propriétaires.

Afin que les algorithmes fonctionnent de façon optimale (répartition entre le processeur et la mémoire vive) avec les technologies « Big Data », d’autres logiciels sont nécessaires. Ici aussi on trouve des possibilités parmi les logiciels libres ou commerciaux qui sont constamment développés.

Une chose est claire : les possibilités de l’analytique prédictive et prescriptive sont loin d’être épuisées.

Industrie 4.0: l’informatisation de l‘industrie

L’industrie 4.0 en tant que projet allemand et européen comprend l’informatisation des techniques de fabrication. Les techniques d’automatisation nécessaires à l’industrie 4.0 doivent devenir plus intelligentes par l’introduction de procédés d’auto-optimisation, d’auto-configuration, d’auto-diagnostic et de cognition et mieux soutenir les hommes grâce à leur travail toujours plus complexe. Il en résulte ainsi une usine intelligente (Smart Factory), polyvalente et efficace en termes de gestion des ressources, et qui s’intègre parfaitement dans le processus commercial d’une entreprise.

Les idées de l’industrie 4.0 sont omniprésentes dans l’industrie suisse, et pas seulement dans le domaine de la production. Le degré de maturité de l’industrie suisse concernant l’industrie 4.0 est très varié. Par exemple, certains précurseurs installent déjà des systèmes de télémaintenance, afin que partout dans le monde des machines installées fournissent des données au fabricant et que les processus de maintenance puissent être mis en place en temps voulu. D’autres opérateurs connectent toute l’usine ou leurs installations industrielles dispersées sur différents sites de façon si centralisée que les données sont utilisables comme un tout. Mais même cette mise en pratique n’est qu’un premier pas dans un monde de l’industrie 4.0, dans la mesure où le « soi », c’est-à-dire la connexion logique et physique des machines n’est pour l’instant que très ponctuellement en croissance.

Un élément important de l’industrie 4.0 est le développement des capteurs mêmes. Par exemple, les capteurs offrent des possibilités totalement nouvelles en matière de mesure de la qualité en direct dans le domaine de la « Vision Industrielle » – c’est-à-dire le domaine de la capture d’images, également dans les longueurs d’ondes IR et X –, ce qui nécessite cependant un très grand volume de données. La spectroscopie est intégrée de plus en plus directement dans les procédés et fourni une très grande quantité de données. Les capteurs modernes sont tout particulièrement caractérisés par des flux de données toujours plus grands, qui doivent être gérés.

De notre point de vue, on accorde trop peu d’importance à l’analytique dans l’industrie 4.0. L’analytique 3.0 et l’industrie 4.0 sont hélas deux mondes hermétiquement séparés. Pourquoi ? Ces deux mondes sont complexes, et seulement partiellement maitrisables dans un premier temps. L’intersection des deux mondes grandit et il ne manque plus que les compétences nécessaires pour les rapprocher.

Industrie analytique 4.0: une étoile est née

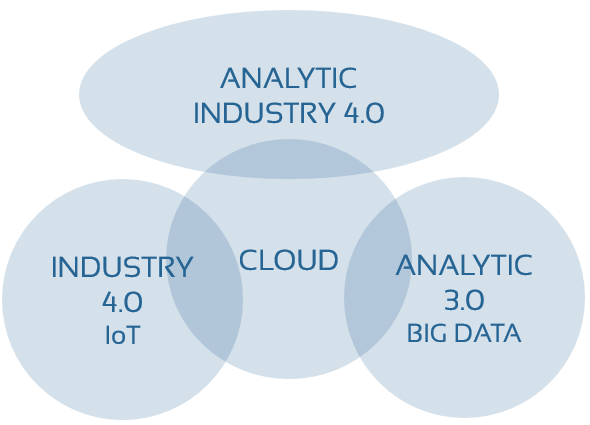

Fig. 2: Cap sur l’industrie analytique 4.0 avec le nuage informatique

Lorsque nous considérons désormais l’intersection des deux mondes, il nous convients alors de la désigner comme l’industrie analytique 4.0. Le nuage informatique (cloud) revêt une grande importance pour rassembler ces deux mondes, car cela consiste finalement à réunir les données en un lieu central. L’industrie analytique 4.0 est une branche de l’industrie 4.0 se concentrant sur la partie analytique de cette quatrième révolution industrielle. Quel est le but d’une telle branche ? Revenons pour cela à la définition de l’industrie 4.0 et identifions l’importance de l’analytique :

- Auto-optimisation : Comparé à l’activité physique d’une machine, l’auto-optimisation du procédé de fabrication est un processus d’optimisation mathématique basé sur des données. Derrière ces processus ne se cachent rien d’autre que les algorithmes de l’analytique 3.0 déjà évoqués.

L’auto-optimisation revêt deux aspects. D’une part, il s’agit de l’optimisation du procédé de fabrication en lui-même. D’autre part, l’attention est également portée sur le produit fini. On peut qualifier une auto-optimisation du procédé de fabrication comme une optimisation automatisée de la qualité. L’optimisation automatisée de la qualité nécessite alors une grande quantité de données, qui doivent être traitées. Afin de pouvoir traiter à temps des informations durant le processus de production, de grandes et performantes structures analytiques sont nécessaires. - Auto-diagnostic : L’auto-diagnostic a comme but de détecter les pannes de machines le plus tôt possible, ce qui passe par la notification de valeurs seuils. La combinaison de données de mesures traitées algorithmiquement, et le rapatriement des informations qui en découlent dans le procédé de fabrication par traitement physique, peut faire office d’auto-diagnostic.

- La cognition est l’ensemble des activités intellectuelles en rapport avec la pensée, le savoir, la mémoire et la communication. Comme le cerveau humain, l’industrie a également besoin d’un recueil de données en tant que base à partir de laquelle le savoir va être généré. Cette base est constituée par l’infrastructure (le Cloud) de l’analytique 3.0.

Il s’agit donc d’aligner l’analytique 3.0 sur la quatrième révolution industrielle qui est en cours. Ce ne sont pas seulement les techniques de fabrication qui sont concernées, mais aussi les techniques de stockage, l’ingénierie des procédés, les techniques de climatisation et les technologies énergétiques. Non seulement les données, mais également les infrastructures, les algorithmes et les outils sont spécifiques à ces industries et doivent être élaborés. De notre point de vue, la communauté des logiciels libres va y jouer un grand rôle. Nous pensons que le but d’une industrie 4.0 sera atteint plus vite grâce aux projets de logiciels libres existants et à venir dans les domaines de l’analytique et du Big Data. Les initiatives de logiciel libre génèrent de nouveaux produits pour l’industrie analytique 4.0.

- TensorFlow - mai 29, 2017

- Moteur rotatif – exemple de détection d’anomalies - avril 4, 2017

- Les 3 scénarios de détection d’anomalies - mars 15, 2017