Am Dienstag, 21. März 2017 führen wir zusammen mit unserem Partner M&F Engineering AG ein einzigartiges Seminar zum Thema „Praktischer Einsatz von Machine Learning und Data Science im industriellen Umfeld“ durch. Das Seminar soll Ihnen einen Einblick in den aktuellen Stand der Technik bezüglich Data Science und Machine Learning ermöglichen und Inputs liefern, wie Profis an das Thema herangehen.

Takeaways

- Wie gehe ich vor, um in der eigenen Firma Potentiale zu identifizieren, wo durch Machine Learning bzw. Data Science echter Mehrwert generiert werden kann?

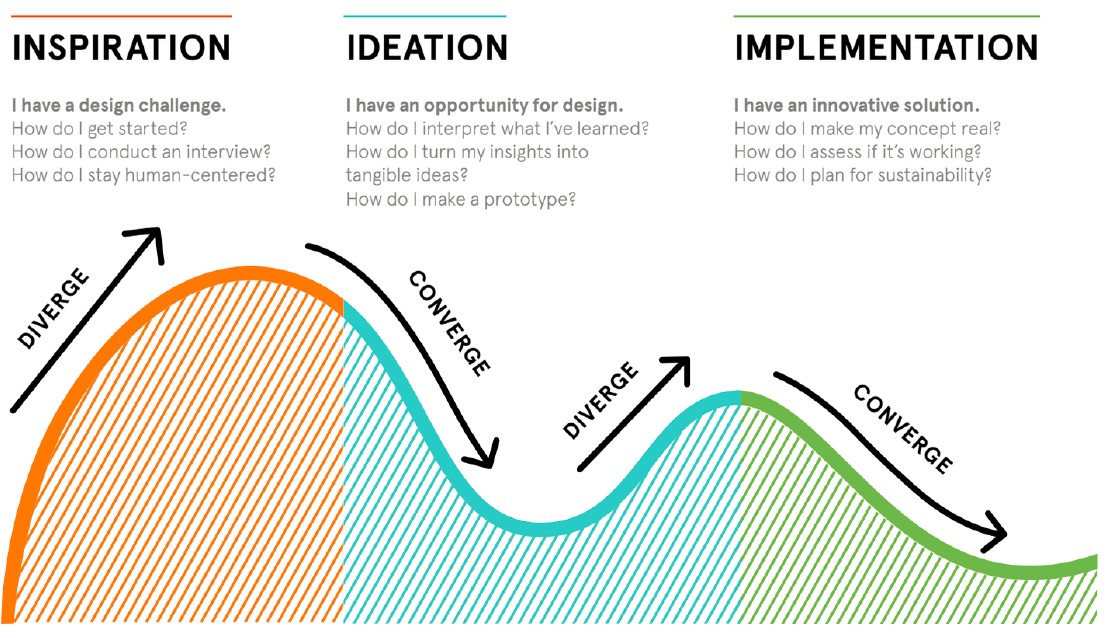

- Wie kann mittels moderner Tools schnell ein Prototyp erstellt werden, um die Machbarkeit der Idee abzuschätzen?

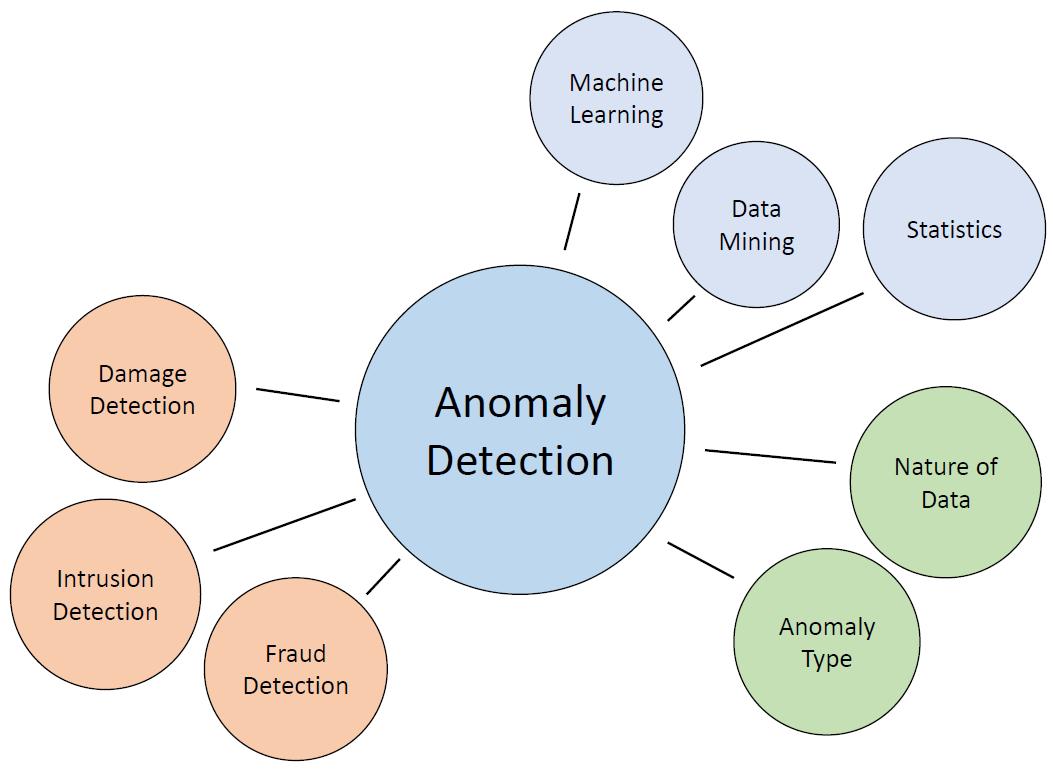

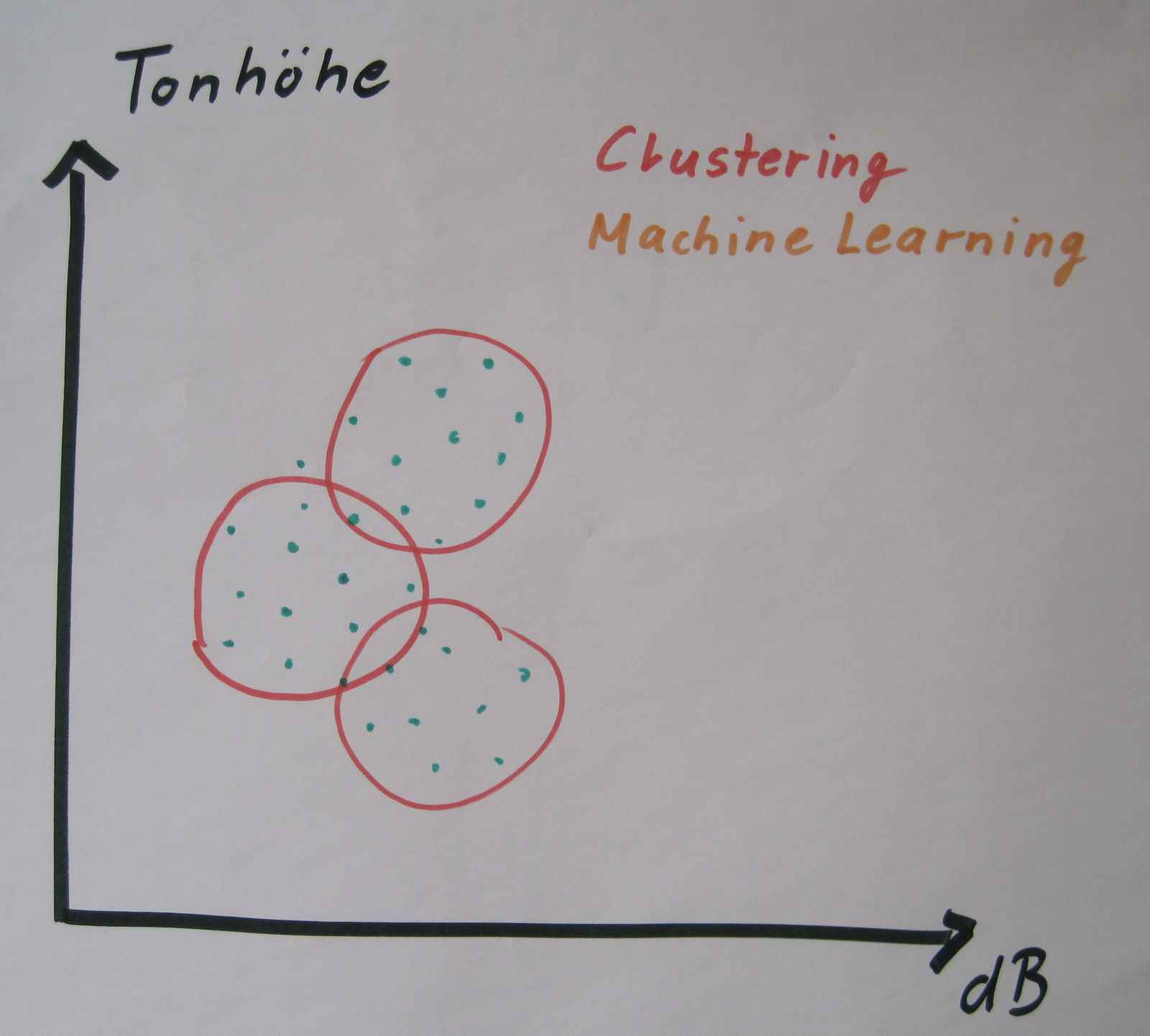

- Welches sind im Moment die meist verwendeten Algorithmen und was können diese?

Die Agenda des Seminars

| ab 8:30 | Registrierung und Kaffee

|

| 9:00 | Begrüssung Reto Bättig, Geschäftsführer, M&F Engineering AG

|

| 9:10 | Einführung (Kurze Vorstellung LeanBI und Data Analytics Use Cases) Marc Tesch, Geschäftsführer, LeanBI AG

|

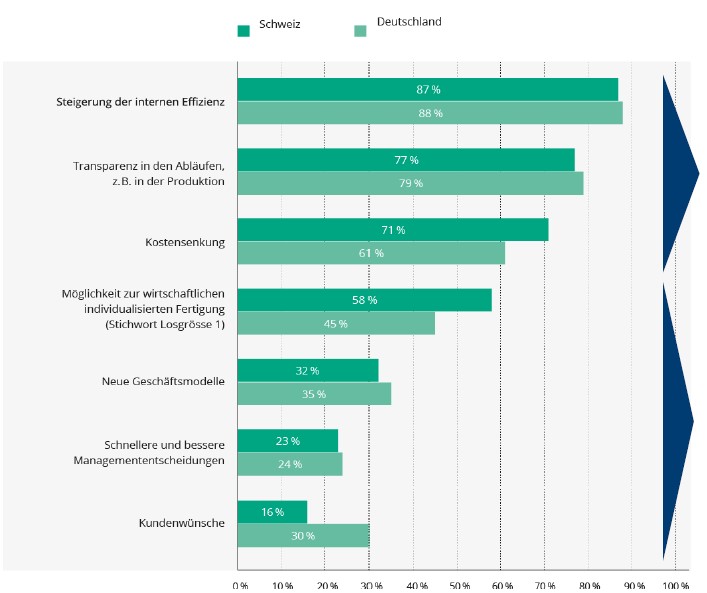

| 9:30 | Der Weg von Big Data zu Nutzen und Wert Wolfgang Weber, Change Management, LeanBI AG

|

| 10:00 | Übersicht über die wichtigsten Algorithmen und deren Möglichkeiten Stefan Pauli, Data Scientist, LeanBI AG Jérôme Bovay, Data Scientist, LeanBI AG

|

| 10:30 | Pause

|

| 11:00 | Fortsetzung Algorithmen und Möglichkeiten Stefan Pauli, Data Scientist, LeanBI AG Jérôme Bovay, Data Scientist, LeanBI AG

|

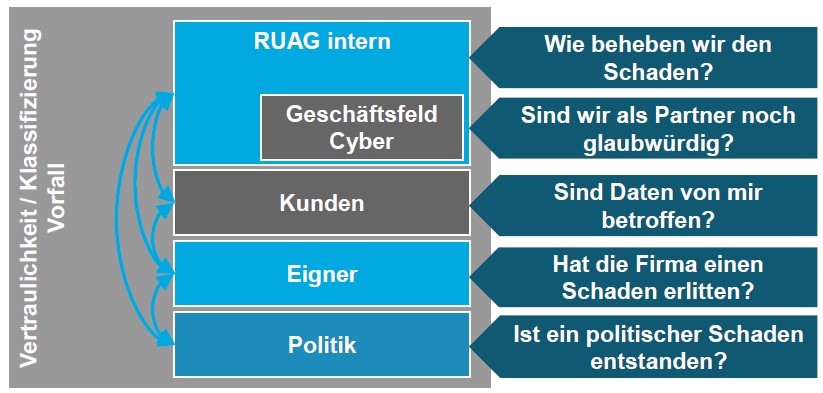

| 11:30 | Data Science Projekt-Beispiel: Geberit Reto Bättig, Geschäftsführer, M&F Engineering AG

|

| 11:40 | Fast Prototyping, Inspiration was ist möglich, Demo Stefan Pauli, Data Scientist, LeanBI AG

|

| 12:15 | Zusammenfassung und Abschlusswort Wolfgang Weber, Change Management, LeanBI AG

|

| 12:30 | Stehlunch |

Anmeldung

Die Veranstaltung ist leider schon ausgebucht. Sie können sich auf die Warteliste setzten lassen. Dies erfolgt über die M&F Engineering Homepage: Hier anmelden. Alternativ können Sie sich auch direkt bei uns melden ( +41 79 247 99 59 oder info@leanbi.ch), um direkt die für Sie spannenden Beiträge zu erhalten.

Dieses Seminar kostet CHF 90.- pro Teilnehmer und beinhaltet eine ausführliche Dokumentation sowie sämtliche Speisen und Getränke. Aus Erfahrung der vergangenen Jahre ist dieses Seminar immer nach kürzester Zeit ausgebucht. Wir empfehlen Ihnen, Ihren Platz jetzt gleich zu buchen.

Veranstaltungsort

Das Seminar findet bei unserem Partner M&F Engineering AG an der Querstrasse 17 in 8951 Fahrweid statt.