Mit Predictive Analytics (Vorausschauender Analytik) können wir Qualitäten besser kontrollieren. Und wir können den Herstellprozess damit optimieren. Im Folgenden wird aufgezeigt, wie wir dabei vorgehen.

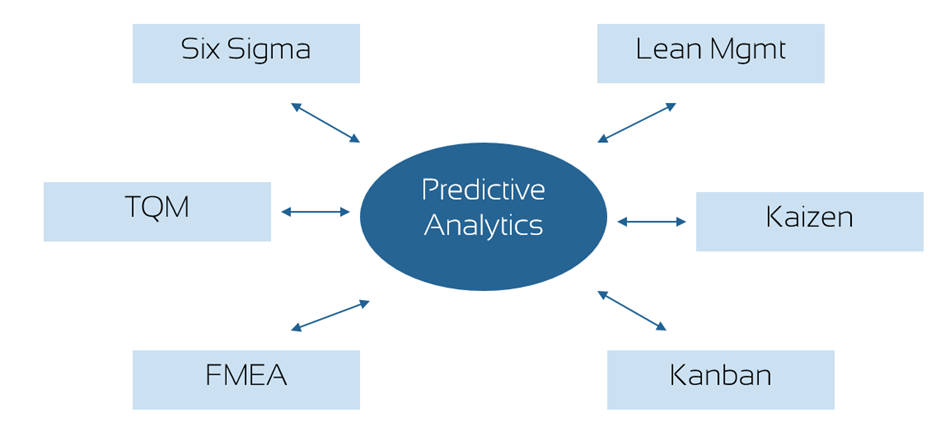

Wir kennen die Methoden der Prozessoptimierung wie TQM (Total Quality Management), Kaizen, Six Sigma, FMEA (Fehlermöglichkeit- und Einflussanalyse) oder Lean Management. Alle diese Methoden haben zum Ziel, die Prozesse in den Industrien (kontinuierlich) zu verbessern. Und alle diese Methoden haben vielen Industrien einen hohen Qualitätsstandard verschafft. Die Prozessoptimierung mit Predictive Analytics ist keine neue Methodik in dieser Kategorie, sondern unterstützt bestehende Qualitätsmethoden in zusätzlichen Dimensionen. Denn um einen Prozess mit Qualitätsmethoden optimieren zu können, muss immer und immer mehr gemessen werden. Nur wenn Daten vorhanden sind, kann auch Wissen generiert werden. Und eine Datenanalyse kann man unterschiedlich intensiv betreiben. Predictive Analytics geht die Datenanalyse so an, dass Schwankungen im Prozess frühzeitig erkannt werden und damit der Prozess gegebenenfalls auch gesteuert werden kann.

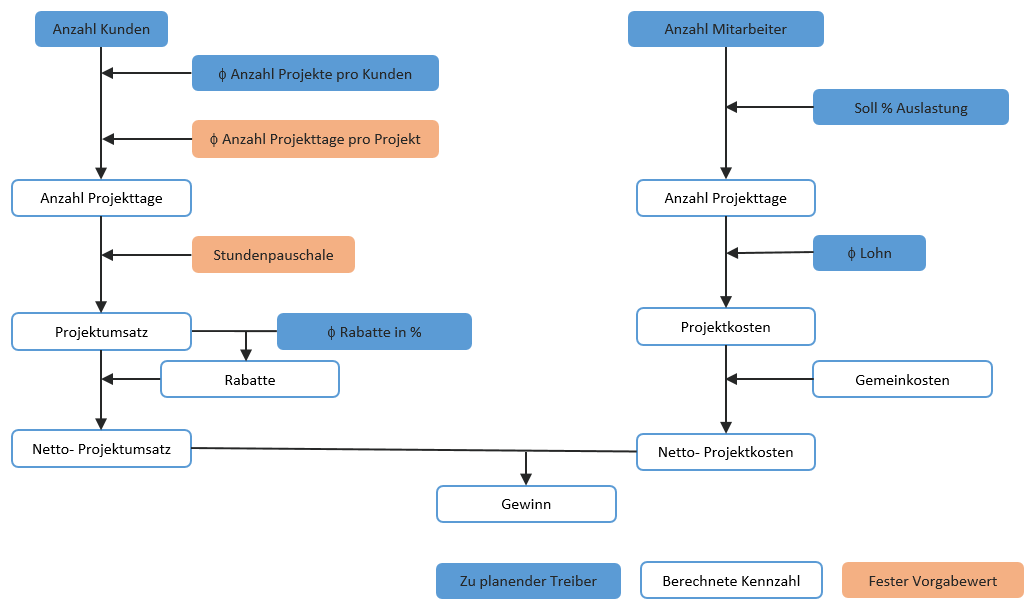

Abb.1: Methoden der Prozessoptimierung und Predictive Analytics

In der Produktion fallen viele Messdaten an. Diese werden teilweise in den MES (Manufacturing Execution Systems) oder computerunterstützen Steuerungen gespeichert. Das Monitoring und die Steuerung haben zum Ziel, den Produktionsprozess möglichst stabil zu halten. Viele der dabei anfallenden Daten sind in dieser Form ein Wegwerfprodukt des Anlagen-Monitoring und der Anlagensteuerung. Die Daten lassen sich aber zusätzlich nutzen, mit Predictive Analytics.

Denn innerhalb eines Prozesses treten immer Fluktuationen der Eingangs- und Umgebungsgrössen auf, die keine Regelgrössen sind, die sich aber trotzdem in Schwankungen der Produktqualität manifestieren. Diese Fluktuationen sogenannter Einflussparameter können sich im Sekundenbereich, Stunden, Tages- oder Wochenbereich abspielen und überlagern sich gegenseitig in ihrer Auswirkung. Zum Beispiel weisen sowohl Zwischen- wie Endprodukte Qualitäts-Fluktuationen in unterschiedlichster Schwankungsbreite auf. In der Prozessindustrie werden periodisch Proben gezogen, die sich im Labor analysieren lassen. Solche Resultate fliessen zeitverzögert in den Prozess zurück, mit dem Ziel auftretende Schwankungen der Produktqualität möglichst klein zu halten. Materialproben können nicht Schwankungen im Minuten oder Sekundenbereich detektieren und geben auch keinen Ausschluss auf die Ursachen der Schwankungen, sind aber nichtsdestotrotz notwendig. Mit vorausschauender Analytik versuchen wir Fluktuationen frühzeitig zu erkennen, um den Herstellprozess entsprechend zu steuern. Wir wollen damit Qualitätsschwankungen im Keim ersticken. Nicht nur Probenentnahmen werden reduziert oder gar hinfällig, sondern die Qualitäten schwanken sehr viel weniger.

Wie gehen bei Predictive Analytics vor?

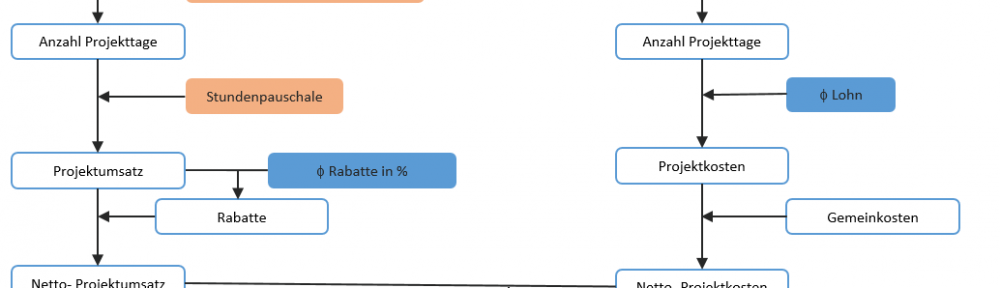

Zuerst nehmen wir eine Liste von Parametern auf, die einen Einfluss auf den Herstellprozess haben könnten. Das sind neben den typischen Anlagenmesswerte auch Einflussfaktoren wie Materialschwankungen von Eingangsmaterialien (deren Qualitätswerte häufig vorliegen), Wettereinflüsse, die sich in Messgrössen wie Aussentemperaturen und Feuchtigkeit niederschlagen, Luftkonvektionen in den Fabrikhallen oder individuelle Maschinenführerdaten, deren Einfluss bislang nicht quantifizierbar war. Es kann also erforderlich sein, zusätzliche Messpunkte zu definieren, um einen möglichen Einfluss dieser Parameter analysieren zu können.

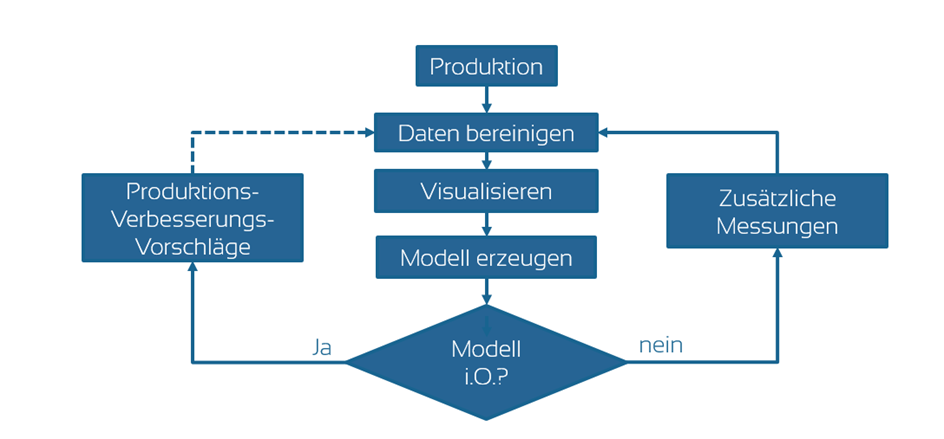

Und dann gehen wir über zur Analytik:

Zuerst nehmen wir die vorhandenen Daten und bereinigen diese bezüglich Ihrer Datenqualität. Dann wenden wir an diesen gefilterten Daten spezielle Visualisierungs- und Analysetechniken an. In Zusammenarbeit mit den Spezialisten in den Firmen können wir bereits in dieser ersten Phase neue Erkenntnisse über den Prozess gewinnen, schon bevor wir algorithmische Modelle anwenden.

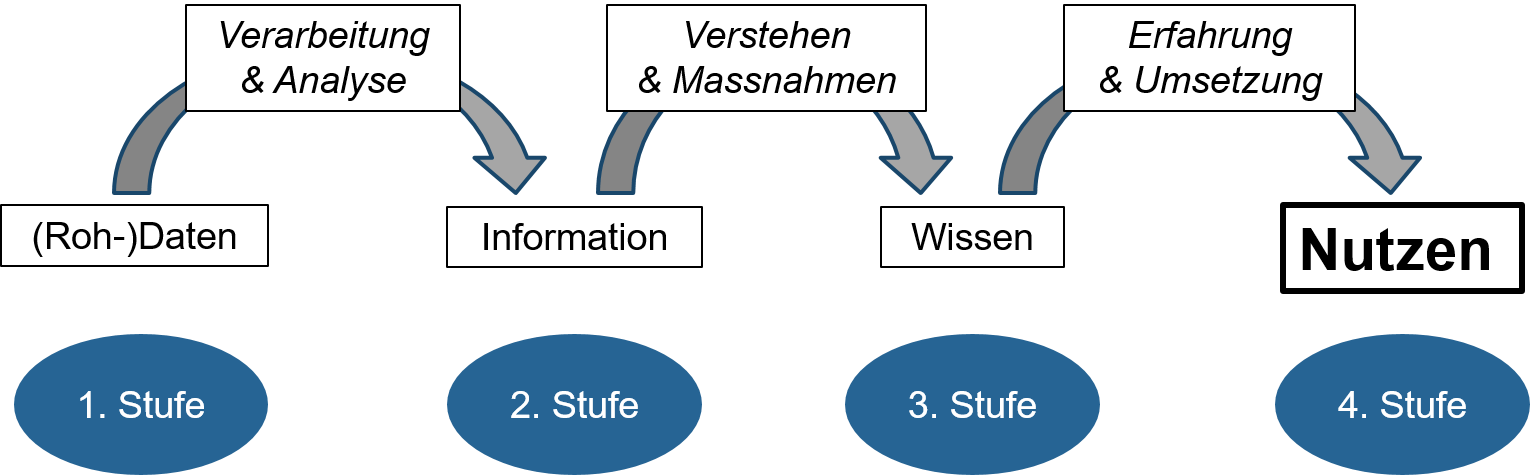

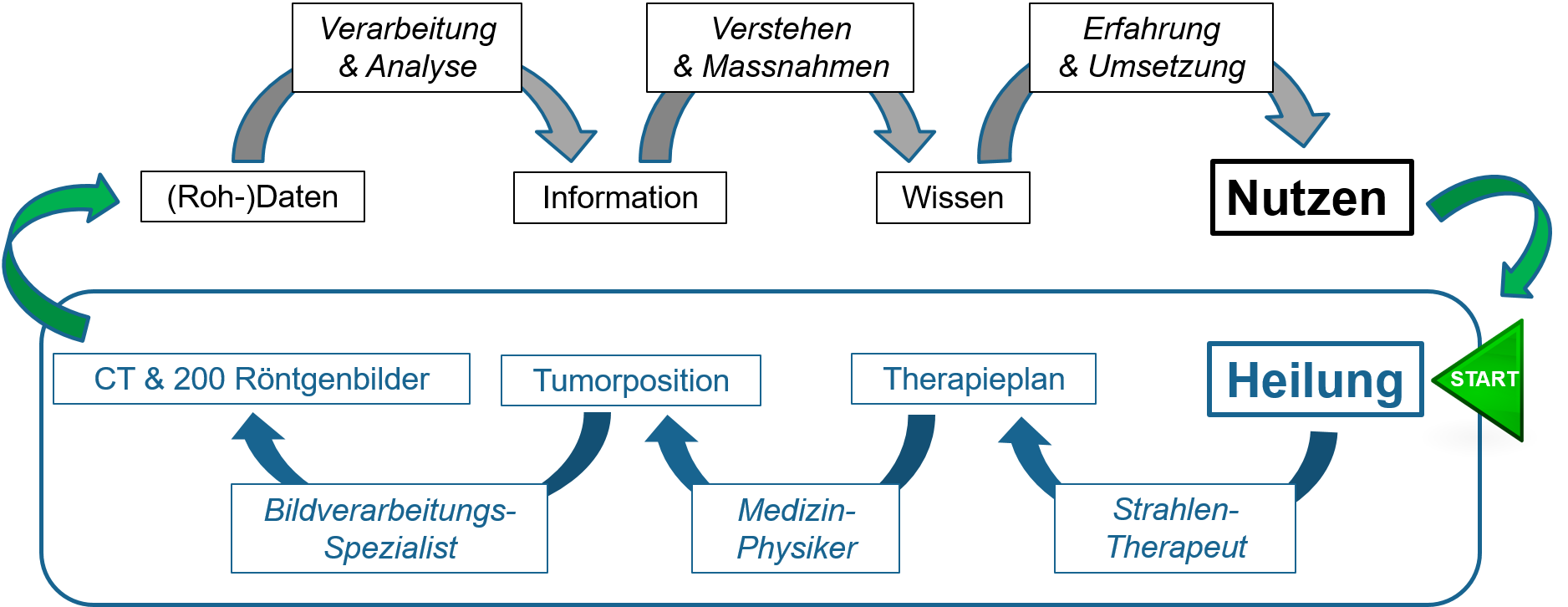

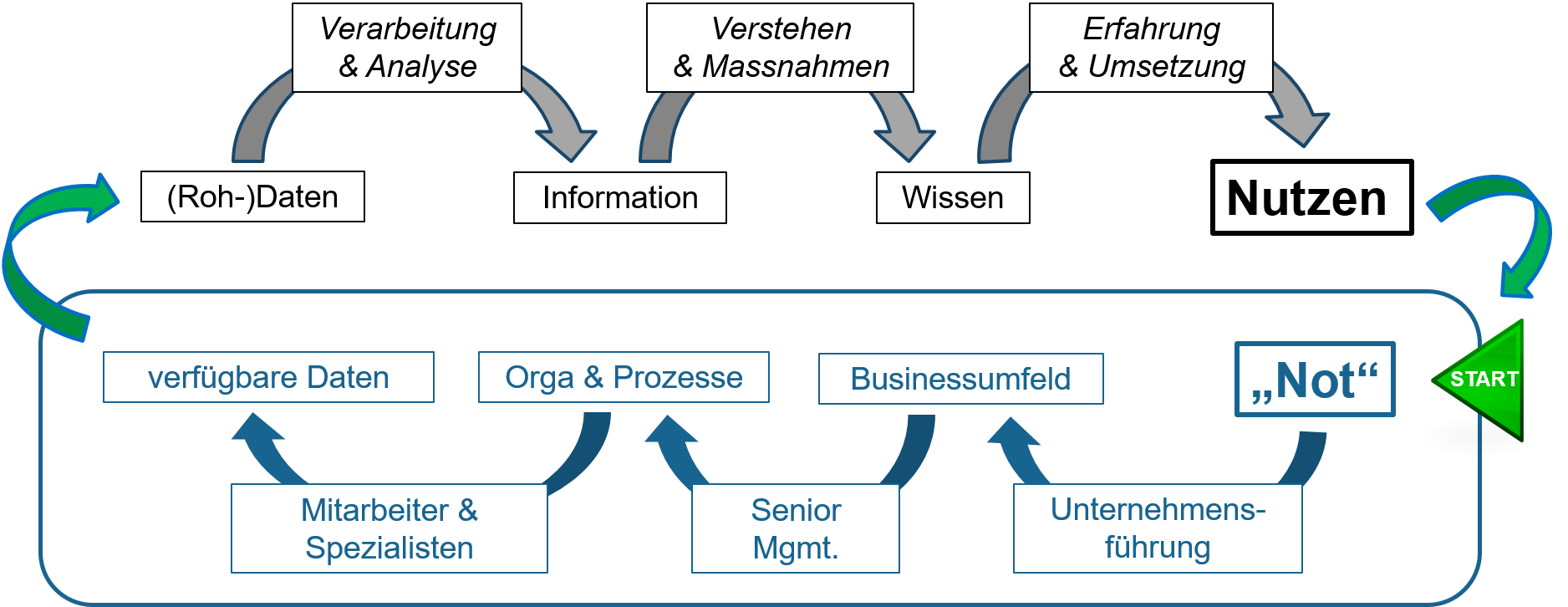

Abb 1. Methodisches Vorgehen bei Anwendung der Predictive Analytic (Vorausschauende Analytik)

Erst im nächsten Schritt gehen wir in die Modellierung über. Dabei wenden wir keine physikalischen, sondern in erster Linie phänomenologische Modelle an. Wir wählen also für die konkrete Aufgabenstellung einen geeigneten Algorithmus aus. Wir trainieren das Modell zu diesem Algorithmus mit einem Teil-Set der vorliegenden historischen Daten und überprüfen dann die Richtigkeit der Modelle mit mehreren anderen historischen Teil-Sets.

Dann wird das Modell im realen Umfeld erprobt. Sollte das Modell die Wirklichkeit noch ungenügend widerspiegeln werden die nötigen Massnahmen getroffen um das Modell zu verbessern. Fehlen beispielsweise Einflussparameter, werden diese neu ins Modell aufgenommen. Möglicherweise haben wir noch nicht genügend Daten gesammelt und müssen dann zurück in den Herstellprozess und zusätzliche Daten erfassen. Dabei wählen wir neue Messpunkte mit hoher Einflusswahrscheinlichkeit.

Wenn wir anschliessend beispielsweise herausfinden, dass die Feuchtigkeit einen Einfluss auf die Produktqualität hat, kann man entsprechende Gegenmassnahmen treffen, indem man die Feuchtigkeitsschwankungen versucht zu verhindern. Die Massnahme an der Quelle- immer die beste- ist aber nicht jederzeit möglich. Dann muss der Prozess aufgrund der Feuchtigkeitsmessung gesteuert werden. Das übernimmt jetzt das Modell: es hat das gesamte Wissen der Vergangenheit gespeichert und kann daraus spezifische Steuergrössen errechnen. Und mit zusätzlichen Messdaten lernt das Modell kontinuierlich hinzu. Das Modell wird über die Zeit immer besser, bzw. passt sich auch an ändernde Prozessverhältnisse an.

Fazit

Die Firma gewinnt dabei in mehrfacher Hinsicht:

- Sie lernt Ihren eigenen Herstellprozess besser zu verstehen.

- Sie kann damit Prozessverbesserungen ausführen, die über die Möglichkeiten der Qualitätsmethoden hinausgehen.

- Sie kann das Modell als Steuergrösse für die Produktqualität verwenden und damit Schwankungen in der Qualität reduzieren.

Notabene: Das sind keine grossen Projekte, von denen wir hier reden. Denn die Applikationen stehen auf Abruf vollumfänglich bei LeanBI zur Verfügung und schon nach wenigen Tagen lassen sich neue Erkenntnisse erzielen.

Photo by Janitors

Photo by Janitors