In an earlier blog we quoted already the mission of the Swiss Alliance for Data-intensive Services:

«Swiss Alliance for Data-Intensive Services provides a significant contribution to make Switzerland an internationally recognized hub for data-driven value creation.”

To transfer this mission into industrial practice and measurable use LeanBi is, besides other enterprises, an early and active member of this coalition:

LeanBI offers data analysis and data modelling workshops to support members in their concrete and daily data based operations and issues.

As the first member of the Swiss Alliance some days ago TRUMPF Laser Marking Systems AG located in Grüsch (GR) conducted such a data workshop together with LeanBI.

TRUMPF Laser Marking Systems AG

TRUMPF is a high-tech company offering manufacturing solutions in the fields of machine tools, laser technology and electronics. TRUMPF is driving the digital networking of the manufacturing industry through consultancy, platform products and software products. With more than 70 subsidiaries TRUMPF is represented worldwide in all major markets.

Fig. 1: Production building TRUMPF Laser Marking Systems AG in Grüsch (GR)

One of these subsidiaries is TRUMPF Laser Marking Systems AG, located in Grüsch (GR) with development and production of Laser Marking Systems. This subsidiary offers a wide variety of marking lasers in many different power classes and with all standard wavelengths (infrared, green, ultraviolet). These lasers are ideal for marking processes such as engraving, ablation, annealing, discoloration, and foaming. In addition to metals, marking lasers from TRUMPF also process many other materials such as plastics, glass, silicon, ceramics and organic substances.

A first workshop: Data analytics and the future use of data

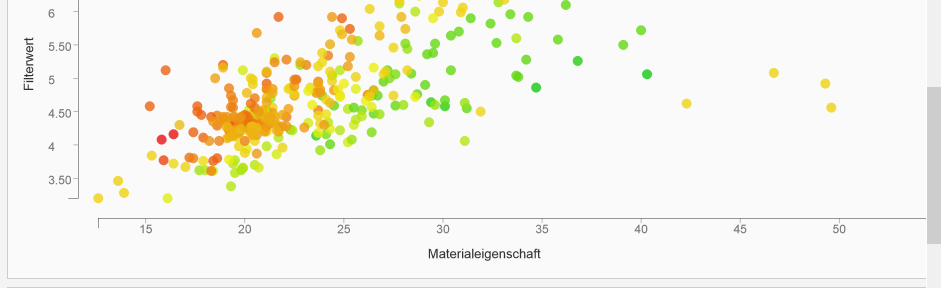

Evaluating the best laser marking settings can be very time consuming, as the optimum marking parameters first needs to be determined. And these parameters are highly material dependent. As a first step to reduce the processing time in application centers significantly, TRUMPF together with LeanBI set up a first common workshop.

The primary objective of this workshop was to get some early insights into what is possible to achieve with analytic algorithms on already available historic marking process data.

In addition to this analysis TRUMPF wanted to identify the main tasks needed to implement structured data collection as a basis. And by this, finally, to reduce costs and the throughput time of application tests for external customers.

First insights of LeanBI’s data analysis

LeanBI created a demo on what is possible with existing data analytics algorithms on existing data with the following results:

- Data quality is one of the most important issues, i.e. the know-how is necessary, which data are really important and in which granularity those data have to be collected one needs to know what has to be to achieved via data analytics and then a standardized way to collect the necessary data into a structured data base has to be implemented.

- Most of TRUMPFs speculations about the influence of all the different laser parameters, which affect the result of the marking quality, were confirmed by the first analysis of LeanBI. On the other hand, there were surprising additional aspects as well.

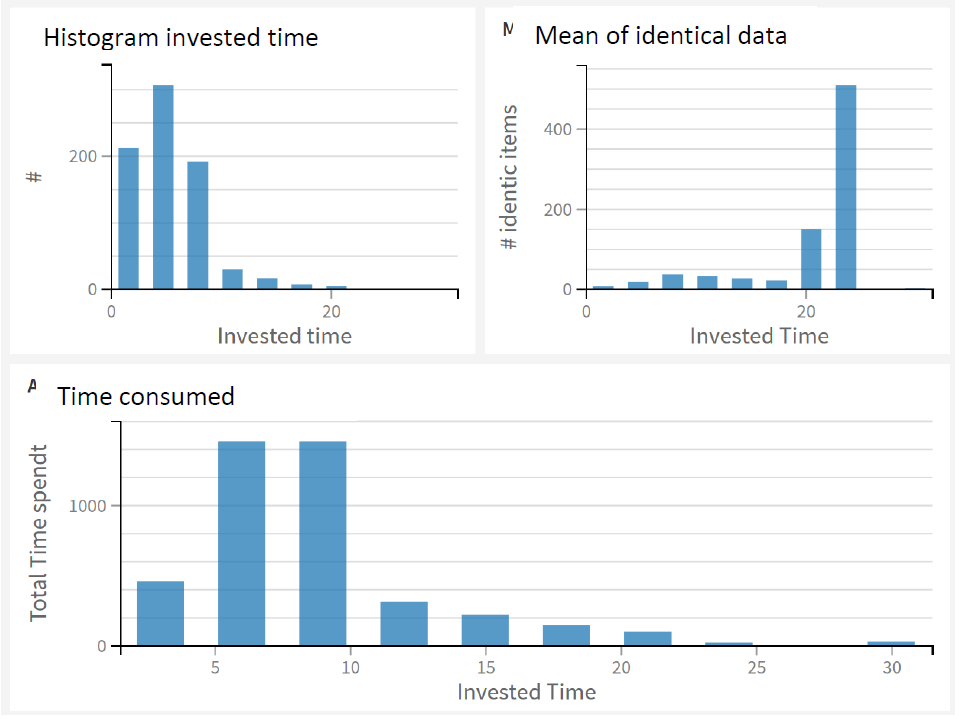

- The overall most time consuming activity in the laser application centers worldwide are application tests for standard objects. The reduction of the processing time for such standard objects is very interesting from an economic point of view.

- One of the big questions is: Is it possible to automate the process for standard laser applications partly or even completely? This would help to save expensive development resources, which then could be used for other, more complex and highly specific projects.

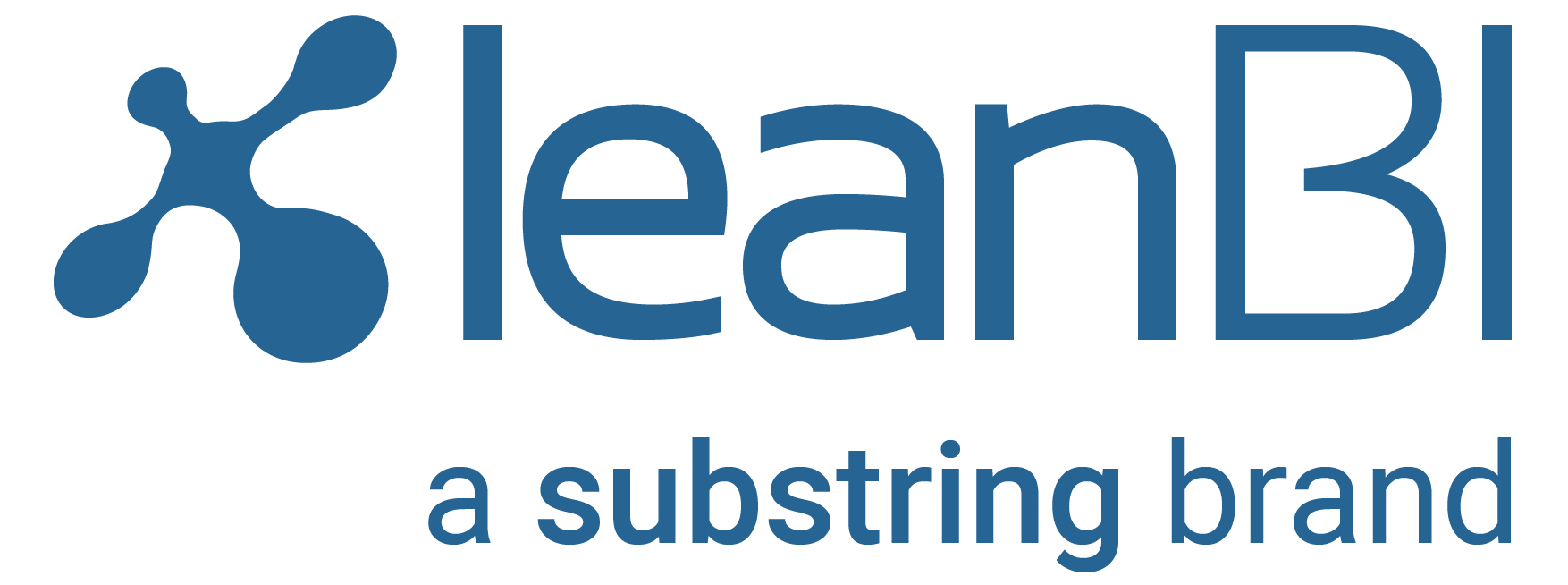

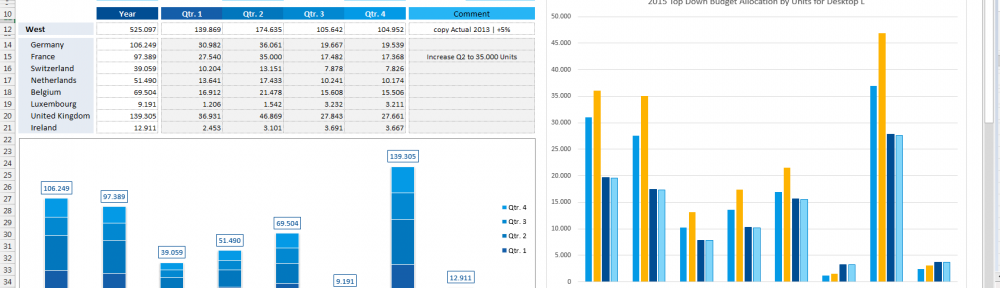

Fig. 2: Evaluation time invested for laser marking process (GR)

A first Pilot Project

During the second part of the workshop also the objective of a first pilot project was defined to use intelligent data analytics algorithms for the prediction of laser parameters based on existing future data. Considering in this pilot project only a very limited field of applications could help to realize a rather quick MVP for valuable results.

The main work packages of this pilot project were discussed and responsibilities were defined in a coarse project plan.

Next steps?

This first pilot project will work as a proof of concept (PoC) and will be the basis for a later complete project roadmap to be set up after successful completion of the PoC. After evaluating the pilot, this roadmap will be generated mainly under economical aspects, i.e. based on the respective business cases.

The “Voice“ of TRUMPF Laser Marking Systems AG

How does Mr. Matthias Werner, project manager digitalization at TRUMPF Laser Marking System AG, comment the workshop results?

«The digital transformation helps us to improve productivity along the whole order-to-cash process. Particularly, in non-value-adding areas we have the biggest technical and economical potentials. In general we work on questions like: How can data help us to make processes more efficient and which data do we need in the future to enable the effective use of intelligent data algorithms?

This is one of the projects, which helps us to improve the productivity of our order-to-cash process.»

LeanBI and Swiss Alliance for Data-intensive Services

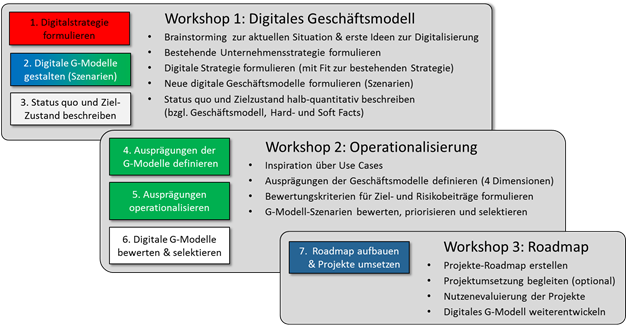

LeanBI offers for all members of Swiss Alliance for Data-intensive Services workshops in the areas of Business Intelligence (BI), Big Data und Industry 4.0.

By this, the mental hurdle to implement use-oriented and data-driven analysis and algorithmic methods shall be lowered. But the purpose is also to support interested companies in their daily operative challenges based on data analytics. In order to generate concrete and measurable use.

At www.data-service-alliance.ch Swiss Alliance for Data-intensive Services shows a list of all of the services available, and also the service provided by LeanBI particularly: «Innovation Bootcamp on Predictive Analytics»:

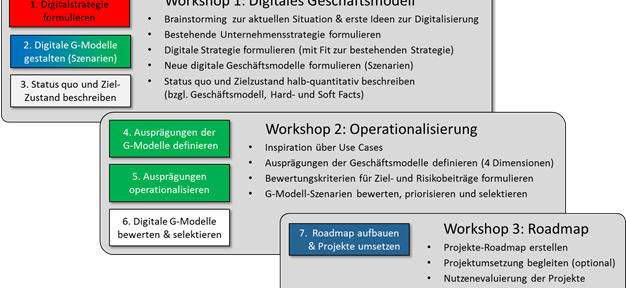

Fig. 3: Services der Swiss Alliance

Conclusion

A first promising step is made.

The data available at TRUMPF Laser Marking Systems AG were converted into first valuable results.

And a coarse planning of a pilot project is done (start in Nov. 2017). The outcome of this project will serve as an important input for a project roadmap to implement further marking process optimizations.